It remains as a dispute over what cues are used by the human brain to determine the labor division of its two hemispheres for speech perception. A research group headed by Prof. CHEN Lin from the University of Science and Technology of China (USTC) recently reported their latest breakthrough on this interesting but long-standing issue, suggesting that hemisphere specialization mainly depends on acoustic cues before speech input is mapped into a semantic representation.

According to

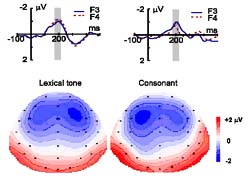

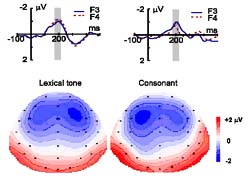

the Proceedings of the National Academy of Sciences (PNAS) published on Dec. 19, 2006, the researchers used the tonal feature of the Chinese language to solve this puzzle. They frequently presented to native Mandarin Chinese speakers a meaningful auditory word with a consonant-vowel structure, and infrequently varied either its lexical tone or initial consonant to create a contrast with a shift in the word's meaning. As revealed by whole-head electric recordings, the lexical tone contrast evoked a stronger pre-attentive response in the right hemisphere than in the left, whereas the consonant contrast produced an opposite pattern.

In opposition to the widely accepted view that the left hemisphere of the human brain is dominant in speech perception, Chen and his colleagues came to conclude that our right hemisphere is responsible for pre-attentive processing of lexical tones before the task is taken over by the left half of the brain.

Regarding what cues are used by the brain for hemisphere dominance, there have been two incompatible hypotheses,

i.e., the functional hypothesis and the acoustic hypothesis. The former holds that the cues are linguistic functions, for example, the lexical meaning of a word. According to this theory, sounds with semantic information are preferentially processed in the left hemisphere. In contrast, the latter claims that the cues are acoustic structures of the auditory input. According to this theory, spectrally variant sounds are preferentially processed in the right hemisphere whereas the temporal variants such as non-tonal speech in the left. With their work, Prof. Chen and his colleagues have been able to bring the two hypotheses into harmony. They found that both hypotheses actually hold and just work at different stages of speech processing in the brain.

It is an ingenious and pioneer work to use Chinese lexical tones as an auditory stimulus for studying this issue and the results have has helped solve the dispute, the reviewer of the article remarked. It is of considerable theoretical significances in understanding the pre-attentive speech processing.

Prof. Chen was a post-doc researcher at the State University of New York and Carleton University of Canada before he came back to China to establish the Hefei-based Auditory Research Laboratory at the USTC in 2002. The research is co-funded by the National Natural Science Foundation of China, the National Basic Research Program as well as the CAS Knowledge Innovation Program.